Yapay Zekâ Ön Yargısı Nedir?

Yapay zekâ; günümüzde sağlık, ulaşım ve finans gibi alanlarda sağladığı faydalarla toplumları geliştirme ve dönüştürme potansiyeline sahip.

ArtemisDiana /İStock

Yapay zekâ destekli karar verme sistemleri, büyük miktarda veriyi analiz ederek başarılı tahminlerde ve önerilerde bulunabiliyor. Bu sayede birçok alanda hızlı ve doğru kararlar alınabiliyor. Ancak bu sistemlerin farkında olmadan mevcut sosyal ön yargıları güçlendirebileceği yönünde artan bir endişe var.

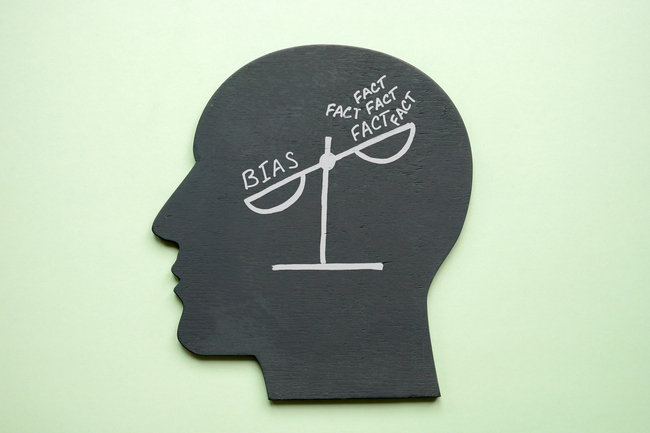

Ön yargı; bir kişi, grup, olay veya konu hakkında önceden oluşturulmuş, genellikle olumsuz ve eleştirel bir yargıdır. Örneğin “Erkekler duygusal değildir.” ya da “Kadınlar zor işleri yapamaz.” gibi yargılar, bireylerin düşünce, tutum ve davranışlarını etkileyebilir. Ön yargılar genellikle bilgi eksikliği, yanlış yönlendirilme veya sosyal çevre tarafından şekillendirilir.

designer491 / iStock

Aslında hepimiz ön yargılara sahibiz ve bunlar dünyayı daha hızlı ve kolay bir şekilde anlamamıza yardımcı oluyor. Çünkü ön yargılar sayesinde bilgi işleme süresi kısalıyor. Ancak ön yargılar aynı zamanda, yukarıda saydığımız nedenlerle adil ve doğru kararlar almayı da zorlaştırabilir. Çünkü ön yargılarımıza dayanarak bilgiyi seçici bir şekilde değerlendirebiliyoruz. Yani hızlı öğrenmek ve kararlar almak için kimi gerçekleri göz ardı edebiliyoruz.

Peki yapay zekâ nasıl ön yargılı olabilir? Bu sorunun cevabı yapay zekâ teknolojisinin insan hayatı ile ne kadar ilişkili olduğunu gösteriyor. Çünkü yapay zekâ sistemlerinin eğitildiği binlerce terabayt büyüklüğündeki veriyi insanlar üretiyor. Yani yapay zekâ aslında insanlığın yüzyıllardır ürettiği bilgileri öğrenerek gelişiyor. Bu süreçte sadece bilgileri değil, insanların sahip olduğu ön yargıları da öğreniyor. Dolayısıyla verdiği kararlar ve ürettiği içerikler bu ön yargılardan etkilenebiliyor.

Bu konudaki en meşhur örneklerden biri Amazon şirketinin işe alım süreçlerinde yaşandı. 2018 yılında Amazon, işe alım süreçlerini kolaylaştırmak için bir yapay zekâ sistemi kullandı. Buna göre sistem ilk defa işe başvuran adayların CV’lerini inceliyor ve bir kısmını eleyerek, insan kaynaklarında çalışan kişilerin işlerini kolaylaştırıyordu. Ancak kısa süre sonra, sistemin kadın adaylara karşı ön yargılı olduğu ortaya çıktı. Sistem, on yıl süreyle gönderilen öz geçmişlerle eğitilmişti ve bu süre zarfında çoğu başvuru sahibi erkek olduğu için yapay zekâ erkek adaylara yönelik ağırlıklı bir tercih geliştirmişti. Amazon mühendisleri sistemi düzeltemediler ve en sonunda kapatmak zorunda kaldılar.

Galeanu Mihai / iStock

Yapay zekâ ön yargısının bir başka örneği ise önleyici polislik hizmetlerinde ortaya çıktı. Bu amaçla ABD’de uygulamaya koyulan yapay zekâ sistemleri, suçları tahmin etmek ve polis kaynaklarını doğru yönetebilmek için kullanıldı. Ancak bu sistemler genellikle geçmişte işlenen suç verilerine dayanır ve bu veriler belirli milliyetlere yönelik sistematik ön yargılardan etkilenebilir. Sonuçta, bu sistemler nedeniyle özellikle siyahi vatandaşların daha yoğun bir denetime tabi tutulduğu anlaşıldı.

m-gucci / iStock

Önleyici polislik, suçları işlenmeden önlemek amacıyla alınan güvenlik tedbirleridir.

Yapay zekâ ön yargısına diğer bir örnek de üretken yapay zekâ araçlarında görüldü. Princeton Üniversitesinde yapılan bir çalışma, farklı dilleri öğrenen bir yapay zekâ sisteminin kaçınılmaz olarak insanların ön yargılarını da öğreneceğini gösteriyor. Örneğin üretici bir yapay zekâ uygulamasının erkek isimlerini “yönetim” ve “maaş” gibi kelimelerle daha güçlü bir şekilde ilişkilendirdiği belirlendi. Uygulama kadın isimlerini ise “ev” ve “aile” gibi kelimelerle daha güçlü bir şekilde ilişkilendiriliyordu. Yani yapay zekâ uygulaması kişileri cinsiyetlerine göre ayıran bir ön yargıya sahipti.

Thapana Onphalai / iStock

Bir başka araştırmada ise Stable Diffusion isimli, yapay zekâya dayalı metinden görüntü oluşturan bir uygulama kullanılarak 14 meslek dalı ve suçla ilgili 3 kategori için binlerce görsel oluşturuldu ve sonuçlar analiz edildi. Sonuçlara göre kadınların ve koyu tenli insanların yüksek maaşlı işlerin görsellerinde çok az, düşük maaşlı işlerin görsellerinde ise çok fazla yer aldığı görüldü. Örneğin ABD’deki yargıçların %34’ü kadın iken, “yargıç” anahtar kelimesi için üretilen görsellerin sadece %3’ünde kadın temsilleri yer alıyordu.

Modelin “fast food” anahtar kelimesi için üretilen görsellerde ise çalışanların %70’i koyu tenli insanlar olarak temsil ediliyordu. Oysa ABD’deki fast food restoranlarında çalışanların %70'i beyaz tenli.

Suç kategorisindeki anahtar kelimelerde ise daha fazla ön yargı tespit edildi. Modelin “mahkum” anahtar kelimesi için ürettiği görseller arasında açık tenli her bir kişiye karşılık beş koyu tenli insan görseli ortaya çıkardı. Oysa ABD hapishanelerindeki mahkumların yarısından daha azı koyu tenli.

Ayrıca “terörist” anahtar kelimesi için ürettiği görsellerin neredeyse tamamında koyu sakallı veya baş örtülü insanlar yer aldı.

Bu örnekler gösteriyor ki yapay zekâ sistemleri hayatımıza daha fazla nüfuz ettikçe ve karar alma süreçlerinde daha fazla yer aldıkça yapay zekâ ön yargısı çeşitli haksızlıklara ve yanlış kararlara yol açabilecek. Bize düşen ise yapay zekâ araçları ile çalışırken bu ön yargılara dikkat etmek ve elde ettiğimiz çıktıların bu ön yargılardan etkilenmediğinden emin olmak.

Kaynaklar:

- https://www.cs.princeton.edu/~arvindn/publications/language-bias.pdf

- https://www.theguardian.com/technology/2018/oct/10/amazon-hiring-ai-gender-bias-recruiting-engine

- https://www.bloomberg.com/graphics/2023-generative-ai-bias/

Yazar Hakkında:

Özgür Kurtuluş

Dijital İletişim Uzmanı